SEO Optimierung – Tipps für ein besseres Google-Ranking

Grundlagen OnPage-/ OffPage-SEO

Nach einer Einführung in die Grundlagen der OnPage- und OffPage-Optimierung werden in Punkt 2 die wichtigsten Änderungen des Google-Ranking-Algorithmus der letzten Jahre vorgestellt. Dabei wird unter anderem auf den möglichen Einfluss von Nutzersignalen wie der Click-Through-Rate (CTR) und dem Pogo Sticking auf das Google-Ranking eingegangen. Auch die Funktionsweise von Googles Künstlicher Intelligenz RankBrain wird erläutert. Da Backlinks nach wie vor ein wichtiger Rankingfaktor sind, widmet sich der dritte Punkt dem Thema Linkbuilding. Der nächste Punkt behandelt die 10 wichtigsten OnPage-Aspekte für die konkrete Optimierung von Websites. Anschließend werden 5 häufig gestellte Fragen zur SEO-Optimierung beantwortet. Den Abschluss bilden erfolgversprechende allgemeine SEO-Tipps für Fortgeschrittene und SEO-Content-Tipps für 2024.

Inhaltsverzeichnis

- SEO Optimierung – Tipps für ein besseres Google-Ranking

- Die 10 wichtigsten SEO OnPage-Aspekte

- Häufige Fragen zum Thema SEO

- Welche SEO-Tipps können eine Website auch in Zukunft nach vorne bringen?

- Zusammenfassung: Die Evolution der Suchmaschinenoptimierung – Die Feinheiten für ein besseres Ranking verstehen

Grundlagen OnPage-/ OffPage-SEO

Im Prinzip ist das Schlagwort „SEO Optimierung“ redundant, denn SEO steht bereits für „Search Engine Optimization“, auf Deutsch Suchmaschinenoptimierung. Mit SEO wird die Gesamtheit aller Maßnahmen bezeichnet, die das Ziel haben, eine Webseite in den organischen Ergebnissen von Suchmaschinen höher erscheinen zu lassen. Von den organischen Suchergebnissen kann die Suchmaschinenwerbung (kurz: SEA – Search Engine Advertising) unterschieden werden, die zum Beispiel bei Google über Ads (früher AdWords) gesteuert wird.

Grundsätzlich kann bei SEO zwischen OnPage- und OffPage-Optimierung unterschieden werden. OnPage Maßnahmen finden auf der Website statt, während OffPage SEO alle Maßnahmen umfasst, die außerhalb der eigenen Website stattfinden. Prominentestes Beispiel für OffPage SEO ist das Linkbuilding – wobei Backlinks heute nur noch eine relative Einflussgröße darstellen. Google hat seine Algorithmen zwar mittlerweile mit zahlreichen Filtern gegen Linkspam ausgestattet, dennoch sind Anzahl und Qualität der Backlinks einer Seite nach wie vor entscheidend für deren Ranking.

Möchtest du wissen, wie gut deine Website wirklich ist? Nutze jetzt die Chance und starte unseren kostenlosen Website-Check! Mit nur einem Klick kannst du wertvolle Erkenntnisse gewinnen und erfahren, welche Optimierungspotenziale deine Website birgt. Warte nicht länger und finde heraus, wie du deine Online-Präsenz auf das nächste Level heben kannst! Jetzt kostenlosen Website-Check starten!

Das bekannteste Beispiel für die Bedeutung von Backlinks für die Suchmaschinenoptimierung von Google war in der Vergangenheit der PageRank, benannt nach dem Google-Gründer Larry Page. Dieser hatte zusammen mit seinem Partner die geniale Idee, einzelne Dokumente anhand der Gesamtstruktur des World Wide Web zu bewerten, was in der Praxis bedeutet, anhand ihrer Verlinkung durch andere Dokumente. Die PageRank Toolbar wurde inzwischen eingestellt, der PageRank einer Seite wird aber nach wie vor von Google intern berechnet.

Im OnPage-Bereich kann grob zwischen Content und Technik unterschieden werden. Suchmaschinenoptimierter Content unterscheidet sich von gewöhnlichem Content im klassischen SEO vor allem durch eines: die richtige Verwendung der richtigen Keywords. Keywords (Schlüsselbegriffe) sind im Prinzip die Wörter, mit denen ein Nutzer bei Google & Co. nach einem Produkt oder einer Information sucht. Keywords sind in der Suchmaschinenoptimierung bis heute nicht zuletzt deshalb so wichtig, weil die herkömmliche Suchmaschine mit Hilfe eines Keyword-Analysers den Inhalt eines Dokuments untersucht und dann quasi entscheidet, ob die jeweilige Seite für eine bestimmte Suchanfrage relevant ist.

Hier ein YouTube-Video zum Thema „Funktionsweise von Suchmaschinen“. Matt Cutts, der ehemalige Chef des Google Web Spam-Teams, der in der Vergangenheit so etwas wie die Rolle des inoffiziellen Google Sprechers in Sachen SEO innehatte, erklärt in diesem Video die Funktionsweise von Google & Co. in ihren Grundzügen:

Sie sehen gerade einen Platzhalterinhalt von Youtube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Keywords können auch aus mehreren Begriffen bestehen, in diesem Fall spricht man im SEO von Longtail-Keywords. Die Bedeutung von Longtail Keywords nimmt stetig zu. Unter anderem, weil der Wettbewerb bei vielen allgemeinen Keywords / Suchbegriffen mittlerweile sehr hoch ist. Wie das Sprichwort sagt, kann Kleinvieh auch Mist machen und dementsprechend kann ein Haufen Kleinvieh auch einen Haufen Mist machen, was allemal besser ist, als von vornherein auf nahezu aussichtslose Keywords zu setzen. Hinzu kommt, dass die Spracheingabe auf Smartphones immer beliebter wird und dabei oft ganze Sätze, also im Prinzip Longtail-Keywords, verwendet werden.

Google bildet zunehmend auch sogenannte Keyword-Cluster, also Begriffsfelder, und berücksichtigt dabei sowohl logische als auch erfahrungsbasierte Beziehungen zwischen den einzelnen Begriffen in seinem Ranking-Algorithmus (Stichwort: RankBrain). Um für ein solches Keyword-Cluster ranken zu können, muss die Seite allerdings erst einmal ranken, was im OnPage-Bereich nach wie vor am besten über einen sogenannten Keyword-Fokus funktioniert.

Die oben getroffene Unterscheidung zwischen Inhalt und Technik ist nicht zuletzt deshalb etwas unscharf, weil es als drittes eine Reihe von HTML-Elementen gibt, die Inhalte in bestimmter Weise kennzeichnen und damit sowohl für Browser als auch für Suchmaschinen interpretierbar machen.

Zu diesen HTML Elementen zählen zum Beispiel der Title-Tag, der Description-Tag, die <H>-Tags (Überschriften) und die ALT-Tags bei Bildern. Einen Keyword Fokus zu erzeugen, bedeutet nun, den wichtigsten Suchbegriff einer Seite u. a. im Title-Tag, in der Meta-Description, in den Überschriften, aber auch im Text-Content einer Seite so unterzubringen, dass diese in Bezug auf das gewählte Keyword eine klare und für Suchmaschinen unmissverständliche Ausrichtung besitzt.

Sie sehen gerade einen Platzhalterinhalt von Youtube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Auch im modernen SEO ist gegen eine klare Seitenaussage nichts einzuwenden, zu den oben genannten HTML-Tags sind in den letzten Jahren sogar noch weitere Elemente zur suchmaschinenfreundlichen Strukturierung von Inhalten hinzugekommen, die sogenannten „Structured Data“. Strukturierte Daten – Nomen est Omen – sind strukturierte Inhalte in tabellarischer Form und stellen Inhalte in einer für Suchmaschinen interpretierbaren Weise bereit.

Die bekanntesten Markups sind hier JSON-LD, Microdata und RDFa, wobei Google mittlerweile JSON-LD empfiehlt. In der Praxis der Suchmaschinenoptimierung ermöglichen strukturierte Daten vor allem das Ausspielen von Bewertungen, Bildern, Produktinformationen, Preisen, Events und Terminen in der Suchergebnisliste. Strukturierte Daten erweitern in der Regel das so genannte Page Snippet, das immer aus Seitentitel, Seitenbeschreibung (wenn gesetzt, häufig der Inhalt des Description-Tags) und URL besteht. Man spricht in diesem Zusammenhang auch von „Rich Snippets“. Durch die Verwendung strukturierter Daten können sich Unternehmen von ihren Mitbewerbern abheben und potenziellen Kunden mehr Informationen direkt in den Suchergebnissen bieten.

Insbesondere das Product Markup wurde in den letzten Jahren von Google stark erweitert und gepusht.

Bei angereicherten Product Markups spricht Google inzwischen von „Händlereinträgen“. (Merchant Listings). Diese erfordern spezifischere Produktinformationen und werden nur für Seiten angezeigt, auf denen Nutzer ein Produkt direkt kaufen können.

Es gibt verschiedene Arten von Suchergebnissen, die durch strukturierte Produktdaten verbessert werden können:

- Produkt-Snippets: Eine erweiterte Darstellung von Snippets in den Suchergebnissen, die zusätzliche Informationen wie Bewertungen, Preise und Verfügbarkeit enthalten.

- Beliebte Produkte: Eine visuell ansprechende Präsentation von Produkten, die zum Verkauf stehen.

- Shopping Knowledge Panel: Bietet detaillierte Produktinformationen mit einer Liste von Anbietern.

- Google Bilder: Zeigt annotierte Bilder von Produkten, die zum Verkauf stehen.

Bilder in der Google Search:

Generell ist technisches SEO ein wichtiger Teilaspekt der SEO Optimierung, die bei uns vor allem das Ziel hat, das Google Ranking zu verbessern. Google besitzt einen Marktanteil von knapp 95,7 Prozent (Stand: November 2022) in der deutschen mobilen Online-Suche, sodass es Sinn macht, die Optimierungen in erster Linie auf die Suchmaschine Google.de zu konzentrieren.

Technisches SEO bedeutet konkret, die Technik auf der eigenen Website so zu gestalten, dass den Crawlern der Suchmaschinen keine Hindernisse bei der Analyse der Website im Wege stehen und die Algorithmen diese anschließend optimal bewerten und ranken. Unter Berücksichtigung der Serverkonfiguration und des Quellcodes werden beim technischen SEO Themen wie mobile Optimierung, Pagespeed / Core Web Vitals, Seitenarchitektur, Sicherheit (HTTPS), Verlinkung sowie Crawling- und Indexierungsstatus behandelt.

Folgende Fragen können durch technisches SEO u. a. beantwortet werden:

- Interne Verlinkung: Können Suchmaschinen anhand der internen Verlinkung ermitteln, welche Inhalte besonders wichtig sind?

- Pagespeed Optimierung: Wie können die Ladezeiten bzw. Core Web Vitals weiter verbessert werden?

- Mobile Optimierung: Entspricht die Mobile Optimierung den Google Standards?

- Informationsarchitektur: Ist eine logische und flache Seitenhierarchie vorhanden?

- Crawling Optimierung: Besuchen die Suchmaschinen Crawler die relevantesten Seiten der Website regelmäßig?

- Indexierungsmanagement: Wie kann eine bestmögliche Indexierung der Website ermöglicht werden (Stichwort u. a.: XML-Sitemaps)?

- Duplicate Content: Kommen Canonical Tags und 301-Weiterleitung richtig zum Einsatz?

- HTML-Optimierung: Werden semantische Auszeichnungen optimal eingesetzt?

- Internationalisierung: Werden Sprachen und hreflang-Tags korrekt verwendet?

- Status Codes: Gibt es verlinkte Seiten, die 404 (Not found) oder 5xx (Server Errors) Fehler zurückgeben?

Modernes SEO – User rückt in den Fokus

Modernes SEO unterscheidet sich von klassischen Strategien dadurch, dass es auch auf den User zugeschnitten ist und nicht nur auf die Suchmaschine. User Experience und User Intent werden in der Suchmaschinenoptimierung immer wichtiger.

Ein Blick auf die wichtigsten Google-Algorithmus-Updates der letzten zehn Jahre zeigt die tiefgreifenden Veränderungen in der Suchmaschinenoptimierung. Penguin & Spam Updates (Links), Panda (Content) und Hummingbird (Content & Semantic Search) haben in der SEO-Welt große Wellen geschlagen.

Wie bereits weiter oben erwähnt, hängt der Erfolg einer Suchmaschine davon ab, ob sie in der Lage ist, für die jeweilige Suchanfrage ein Suchergebnis zu liefern, das der Intention des Nutzers entspricht. Vor diesem Hintergrund ist es nicht verwunderlich, dass auch die Reaktion des Suchenden auf das angezeigte Ergebnis in den Algorithmen eine immer größere Rolle spielt.

Über die Bedeutung des Nutzerverhaltens als entscheidendes Kriterium in SEO besteht heute grundsätzlich Einigkeit. Uneinigkeit herrscht lediglich darüber, wie weit Google bei der Erfassung des Nutzerverhaltens geht. Hier ist anzumerken, dass die Aussagen von Google über den eigenen Ranking-Algorithmus sehr spärlich sind, so dass dieser in weiten Teilen eine Black Box darstellt, deren genaue Funktionsweise nicht bekannt ist. Noch schwieriger ist es, die Interdependenzen zwischen den einzelnen Faktoren einzuschätzen.

Es ist davon auszugehen, dass Google alle Suchdaten auswertet, so auch das sogenannte Pogo Sticking. Von Pogo Sticking spricht man, wenn der Suchende eine Seite aufruft, diese aber direkt wieder verlässt und zu den SERPs zurückkehrt. SERP ist die Abkürzung für “Search Engine Result Page”. Auf einer SERP listen Suchmaschinen die Suchergebnisse nach absteigender Relevanz auf.

Nachfolgend eine vereinfachte Darstellung des Pogo Stickings:

Social-Media-Signale sind vermutlich auch Teil des Ranking-Algorithmus, auch wenn dies von Google in der Vergangenheit häufig bestritten wurde, vermutlich eingebettet in eine Art Gesamtkontext der Aktivitäten rund um eine Website. Dieser Gesamtkontext der Aktivitäten könnte auch als „Buzz“ bezeichnet werden.

Vor einigen Jahren gab es in der Suchmaschinenoptimierung einen großen Hype um die Klickrate in den Suchergebnissen. Grundsätzlich wird die so genannte Click-Through-Rate (CTR) maßgeblich vom Seitentitel, der Meta-Description und eventuell vorhandenen Rich Snippets bestimmt. Hier sollen – nach Aussagen verschiedener SEOs – in der Vergangenheit auch Manipulationen möglich gewesen sein. In der Regel konnten jedoch nur temporäre Erfolge erzielt werden. Im Gegensatz zu Links, die zumindest einen Webmaster mit einer Seite, im Falle einer gut sichtbaren Seite sogar einer erfolgreichen Seite erfordern, die etwas zu verlieren hat, war hier die Schwelle für eine erfolgreiche Manipulation der Suchergebnisse wohl einfach zu niedrig angesetzt.

Google bejaht zwar grundsätzlich, die CTR zur Verbesserung der „Search Quality“ zu verwenden, geht aber nicht so weit, von einem eigenständigen Rankingfaktor zu sprechen.

Wir gehen davon aus, dass die CTR im Prinzip ein nicht unwichtiger Bestandteil des Suchalgorithmus ist. Vor allem in Kombination mit Signalen wie dem Pogo-Sticking ergibt sie ein valides Signal für die Relevanz eines Suchtreffers.

In jedem Fall muss die jeweilige Seite erst einmal ausreichend Traffic besitzen, damit Google aussagekräftige Ergebnisse in Bezug auf die CTR erhält. Hierzu kann Google auch mit zeitlich begrenzten Testszenarien arbeiten, Seiten beispielsweise einen temporären Bonus geben, etwa beim Start der Seite, um die CTR, aber auch andere relevante User-Signale, zu ermitteln, um anschließend die Website u. a. vor diesem Hintergrund (neu) zu bewerten. Die Aussagen von Google zu dem Thema deuten auf jeden Fall auf ein solches oder ähnlich gelagertes Szenario hin.

Zusätzlich muss sich die gemessene CTR wahrscheinlich auch im groben Rahmen der von Google aus seinen bisherigen Daten ermittelten Erfahrungswerte befinden. Festzuhalten bleibt, dass sich die Datenkrake Google die gesammelten Daten über die CTR und Absprungrate zur Verbesserung der eigenen Suche mit sehr hoher Wahrscheinlichkeit nicht entgehen lässt, diese jedoch nur eingeschränkt und in sehr komplexen und zum Teil dafür eigens erzeugten Szenarien als wichtiger Bestandteil des Ranking-Algorithmus gelten können.

Click Through Rate (CTR) als Kennzahl (orangene Linie) in der Google Search Console:

Im Zusammenhang mit dem Stichwort „User Intent“ sollte auch auf Googles 2015 vollständig ausgerollte AI (Artificial Intelligence) namens RankBrain hingewiesen werden, die inzwischen der drittwichtigste Faktor im Google Algorithmus ist und bei ca. 15% der Suchanfragen greift.

RankBrain – Googles Artificial Intelligence in der Suche

Grundlage des RankBrain Algorithmus ist ein von Google 2012 eingereichtes Patent mit dem Titel „Using concepts as contexts for query term substitutions”. Dieses Patent hat den ungefähren Inhalt, Konzepte („concepts“) menschlicher Sprache und eingeschränkt auch menschlichen Verhaltens einzusetzen, um aus dem Kontext (contexts) von Suchanfragen / Suchbegriffen so etwas Menschliches wie „Bedeutung“ oder „Sinn“ zu ermitteln. In der Praxis schreibt RankBrain Text dazu in mathematische Entitäten um, die in diesem Zusammenhang Vektoren genannt werden.

Der zweite wichtige Bestandteil von RankBrain ist Deep Learning. Während beim klassischen Machine Learning feste Modelle zur Identifizierung und Klassifizierung verwendet werden, entwickeln Deep Learning Algorithmen diese Modelle selbstständig weiter oder erstellen sogar neue.

RankBrain kommt vor allem bei Suchanfragen zum Einsatz, die vorher so noch nicht gestellt worden sind. Darunter befinden sich neue Begriffe, in Zeiten von Smartphones und Co. aber auch verstärkt ganze Fragesätze. Dabei greift RankBrain sowohl auf den Hummingbird Algorithmus, der bereits 2013 ausgerollt wurde und erstmals den Sinnzusammenhang von Suchanfragen für Google interpretierbar machte, als auch auf historische Daten zurück. Hummingbird beeinflusst laut Google inzwischen die Suchergebnisse von 90 Prozent aller Suchanfragen.

Google konnte mithilfe von RankBrain in kurzer Zeit tatsächlich seine Suchergebnisse verbessern.

Eine der bekanntesten Verbesserungen stammt aus der US-amerikanischen Google Suche und betrifft Sicherheitslücken beim Portable Document Format, kurz PDF. Die beobachtete Suchanfrage lautete: „why are pdfs so weak“. Mit RankBrain konnte Google im Januar 2016 zweifelsfrei ermitteln, dass es sich hierbei um eine Suche rund um die Sicherheitsstandards bei Adobe PDFs handelt, und ein entsprechendes Ergebnis priorisieren. Im Juli 2015 hatte Google auf diese Suchanfrage hingegen noch die PDF-Version eines Memos des amerikanischen Think Tanks RAND Corporation als ersten Treffer ausgeliefert, das der Frage nachging, warum der Widerstand gegen die Invasion der „Koalition der Willigen“ in den Irak 2003 so schwach („so weak“) ausfiel.

Vor dem Hintergrund der technologischen Entwicklung wird es immer wichtiger, einen holistischen Ansatz in SEO zu verfolgen, der die Gesamtheit der Faktoren erfasst. Keywords bleiben relevant, jedoch gewinnen zunehmend auch Faktoren an Bedeutung, die es ermöglichen, den User Intent am besten zu erfüllen und damit gute User Signale zu generieren.

Es ist – wie oben schon erwähnt – in der Fachwelt weiterhin umstritten, wie weit Google geht, um die User Signale zu erfassen. Benutzt Google auch Datenquellen, die eigentlich nichts mit der Search zu tun haben, wie zum Beispiel Google Chrome, Analytics, Android, AMP oder Google DNS Server?

Wir würden sagen, dass in einem gewissen Rahmen diese Daten sicherlich genutzt werden, z.B. können wir uns vorstellen, dass Google Chrome Userdaten auswertet, was ja von Google mit den Core Web Vitals auch schon offiziell gemacht wird. Diese Daten sind unter anderem eine gute Grundlage, um die Suche grundsätzlich weiter zu verbessern. So können sie beispielsweise Faktoren auf einer Seite identifizieren, die im Durchschnitt eher positive oder negative Nutzersignale auslösen. Sehr unrealistisch erscheint uns hingegen das Szenario, dass z.B. Analytics-Daten in die konkrete Ranking-Berechnung einer Seite einfließen. Denn damit hätten Analytics-Nutzer grundsätzlich andere Startbedingungen im Rennen um die besten Positionen in den Suchergebnissen, was grundsätzlich allen Google-Richtlinien und -Praktiken widersprechen würde.

Wenn konkrete User-Signale in die Rankingberechnung miteinfließen, dann müssen sie zumindest vom Grundsatz her für alle Websites gleich ermittelbar sein.

Über 200 Ranking-Kernfaktoren sind Teil des Google-Algorithmus. Neben den oben genannten Nutzersignalen spielen auch Content und Backlinks eine wichtige Rolle im Ranking-Algorithmus von Google.

Linkbuilding muss immer auch Marketing bedeuten

Da Links nach wie vor ein entscheidender Faktor für den Erfolg oder Misserfolg einer Website oder eines Online-Shops sind, halten wir Linkbuilding nach wie vor für einen notwendigen Bestandteil jeder zielführenden SEO-Strategie. Auch beim Linkaufbau setzen wir auf einen ganzheitlichen Ansatz. Content Marketing und Linkbuilding gehen bei uns fließend ineinander über. So achten wir stets darauf, dass der Backlink natürlich und in einem sinnvollen Kontext gesetzt wird. Sinnvoller Kontext bedeutet konkret, dass sich der Artikel zumindest so weit mit dem Angebot unseres Kunden auseinandersetzt, dass der Link in seinem Umfeld inhaltlich passend, ja geradezu notwendig erscheint. Häufig befasst sich der Artikel auch vollständig mit dem jeweiligen Angebot des Kunden, ohne als Werbung erkennbar zu sein. Durch diese Vorgehensweise können wir in der Regel nicht nur Links, sondern auch zusätzlichen Traffic für die Websites unserer Kunden akquirieren.

Selbstverständlich achten wir bei unserem Linkbuilding neben technischen Faktoren auch auf die thematische Nähe und Ausrichtung der gesamten Internetpräsenz. Wir setzen ausschließlich auf qualitativ hochwertige Webseiten, die sowohl über ausreichend Traffic als auch über eine hohe Sichtbarkeit in den Google Suchergebnissen verfügen. Hierbei orientieren wir uns unter anderem am Sistrix Sichtbarkeitsindex.

Neben dem Linkaufbau bieten wir auch eine Linkbereinigung an. Auch wenn manuelle Abstrafungen selten geworden sind, hat eine Linkbereinigung bereits das Ranking vieler Websites verbessert.

Ergebnis eines Backlink Audits mit Semrush

Lokales SEO

Google und andere Suchmaschinen werden immer häufiger dazu genutzt, um lokale Unternehmen zu finden. Nicht nur hat eine große Anzahl der Suchanfragen einen direkten lokalen Bezug, wie etwa die Suchanfrage „Augenarzt München“, Google versucht auch immer häufiger vor dem Hintergrund des Standortes des Nutzers, die allgemeinen Suchergebnisse mit lokalen Treffern anzureichern. Dennoch wird die Bedeutung der lokalen Suche oft unterschätzt. Dabei sucht die Hälfte der Internetnutzer laut einer Google Studie nach den Adressen von Geschäften, ihren Öffnungszeiten, der lokalen Produktverfügbarkeit oder nach Wegbeschreibungen. Auch wer gerade in Shoppinglaune ist, recherchiert zuvor im Internet, bei den Desktop und Tablet Nutzern sind es laut der Studie 66%, bei den Smartphone Usern 57%. Und 50% der Smartphone-Nutzer und 34% der Computer und Tablet Nutzer besuchten im Anschluss ein Geschäft in ihrer Nähe.

Weitere wichtige Ergebnisse der Google Studie in der Übersicht:

- 80% der Verbraucher nutzen Suchmaschinen, um sich über Lokales zu informieren

- Durch lokale Suchanfragen werden mehr Käufe generiert als durch die nicht-lokale Suche

- 18% der Smartphone Nutzer, die sich über ein Produkt informiert haben, kaufen innerhalb eines Tages. Bei der nicht-lokalen Online-Suche sind es nur 7%.

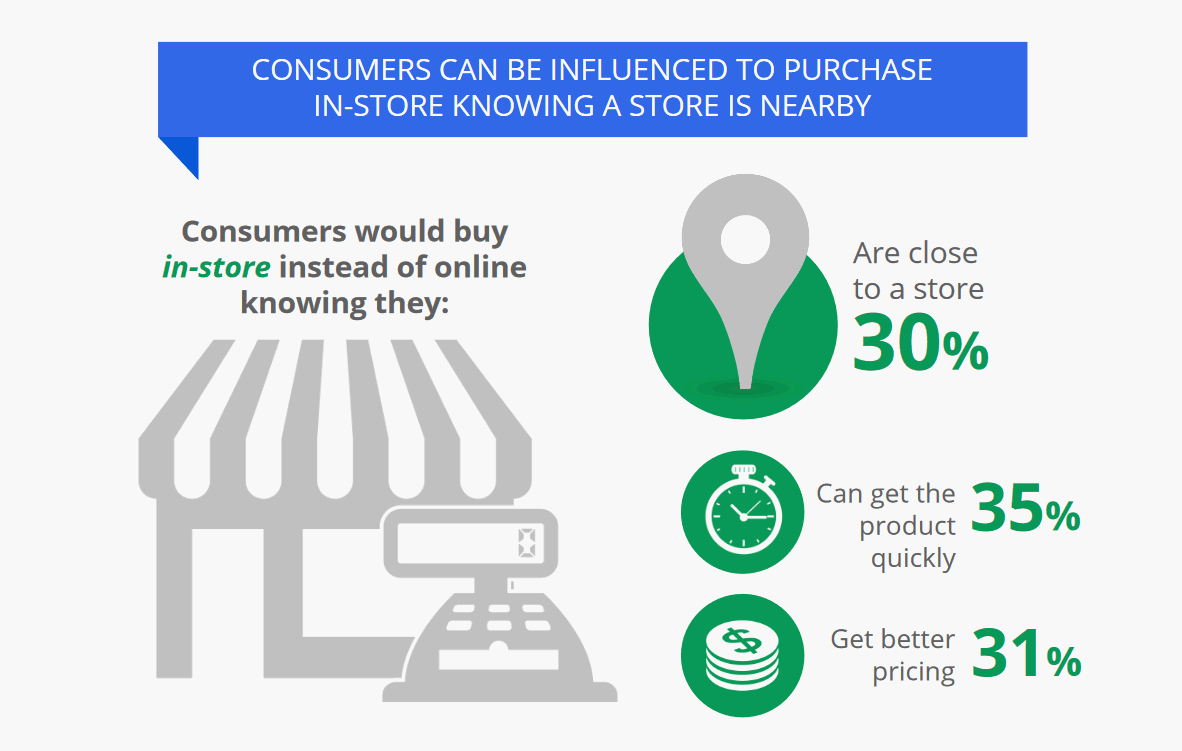

- Wenn der Store in der Nähe ist; bevorzugen 30% ein lokales Geschäft gegenüber einem Online-Shop. 35% ziehen den stationären Handel vor, wenn die Produkte sofort verfügbar sind.

- 53% recherchieren mit ihrem Smartphone, wenn sie etwas in der Werbung gesehen haben, was sie anspricht. Bei den Desktop und Tablet Nutzern sind es sogar stolze 83%.

Wer benötigt lokales SEO?

Im Prinzip jeder, der seine Waren und Dienstleistungen regional anbietet. Sei es eine Anwaltskanzlei, ein Handwerker, ein Friseur, ein Fitnessstudio, ein Restaurant oder eine Filiale eines großen Unternehmens. Wer also ein stationäres Geschäft hat, kann von Local SEO profitieren. AnalyticaA hilft gerne, eine individuelle lokale SEO-Strategie zu entwickeln und umzusetzen.

Was sind die wichtigsten lokalen Rankingfaktoren?

Laut einer Studie der Suchmaschinenexperten von MOZ sind folgende 8 Faktoren für das Ranking in der lokalen Suche entscheidend:

- Google My Business (Nähe, Kategorien, Keyword im Business-Titel usw.)

- Link Signale (verwendete Ankertexte, Domainautorität der verlinkenden Seiten, Anzahl der verlinkenden Domains usw.)

- OnPage Signale (Vorhandensein von Name, Adresse, Telefonnummer; Keywords in den Titeln, Domainautorität usw.)

- Externe Nennungen: Konsistenz der Geschäftsdaten bei Nennungen, Volumen der Nennungen etc..

- Nutzer-Rezensionen (Anzahl, Bewertungsdiversität, etc.)

- Usersignale (Klickrate, mobiles Click-to-Call, Check-in usw.)

- Personalisierung – Nutzer-spezifische Faktoren

- Social Media Signale (Google-Engagement, Twitter-Engagement, Facebook-Engagement)

Hier ein Video von Google zum Thema:

Sie sehen gerade einen Platzhalterinhalt von Youtube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Google My Business

Google My Business ist ein kostenloser Service der Suchmaschine Google. Im Prinzip handelt es sich bei Google My Business um nichts Anderes als um ein digitales Branchenbuch, dessen Einträge von Google auf verschiedene Weise für die Anreicherung der Suchergebnisse genutzt werden. Jeder, der eine konkrete Geschäftsstelle und ein Google Konto besitzt, kann sich hier eintragen – auch Freiberufler. Einträge in Google My Business erscheinen dabei sowohl auf Google Maps als auch in den organischen Suchergebnissen von Google. Folgende Punkte sind bei einem Eintrag in Google My Business unbedingt zu beachten:

- Name, Adresse und Telefonnummer sollten in Google My Business und auf der eignen Website identisch sein.

- Aus den von Google vorgeschlagenen Kategorien sollten unbedingt die passenden gewählt werden. Es ist zu empfehlen, genau zur prüfen, welche Kategorien relevant sein könnten, denn diese fungieren in Google My Business quasi als Keywords.

- Es sollte nur ein Eintrag bei Google My Business vorhanden sein, alte Einträge sollten gelöscht werden.

- Es sollten hochauflösende Bilder hochgeladen werden: Außen, Innen, Produkte, Mitarbeiter. Für die Außenansichten können auch die Google Street View Daten genutzt werden.

Bei der Erstellung eines SEO-konformen Google My Business-Eintrags ist AnalyticaA gerne behilflich.

Die 10 wichtigsten SEO OnPage-Aspekte

Kommen wir nun von der Theorie zur Praxis im OnPage-Bereich. Nachfolgend haben wir die aus unserer Sicht 10 wichtigsten OnPage-SEO-Aspekte aufgelistet:

- Die Website als Ganzes muss überzeugen .

Die Optimierung einzelner Seiten ist nach wie vor wichtig, muss aber in ein stimmiges Gesamtkonzept eingebettet sein. Dazu gehören nicht nur qualitativ hochwertige Inhalte, sondern auch ein optimiertes Design und eine gute Architektur. - Title-Tag

Das Title-Tag ist immer noch einer der wichtigsten und effektivsten Faktoren für die Optimierung einer Seite. Ein optimiertes Title-Tag erhöht die Relevanz einer Seite für bestimmte Keywords bzw. Keyword-Kombinationen (Longtail Keywords) und beeinflusst so direkt die Positionierung. Ein Seitentitel, der den gesuchten Inhalt gut zusammenfasst, wird eher angeklickt als ein kryptischer oder gar leerer Titel. Durch eine höhere Klickrate kann sich das Ranking auf indirektem Weg über die User-Signale verbessern. - Content

Google schätzt grundsätzlich einzigartige, ansprechende und qualitativ hochwertige Inhalte, die dem Nutzer einen Mehrwert bieten. Dabei sollten in den Texten nach wie vor Keywords verwendet werden und im besten Fall auch weitere relevante Begriffe, die in einem bestimmten thematischen Kontext häufig vorkommen (Stichwort: WDF*IDF). Heutzutage empfiehlt es sich, auf eine Universal Content Strategie zu setzen. Universal Content besteht neben Text auch aus Rich-Media-Inhalten wie Bildern, Videos oder interaktiven Buttons. Themen sollten ganzheitlich behandelt werden, aber jede Seite sollte eine klare und eindeutige Botschaft haben, die sich nicht auf der gesamten Website wiederholt. - Architektur und interne Verlinkung

Eine nutzer- und suchmaschinenfreundliche Seitenarchitektur ist von zentraler Bedeutung für die Sichtbarkeit einer Website. Die Architektur sollte logisch und hierarchisch aufgebaut sein und alle Seiten sollten mit maximal 4 Klicks erreichbar sein. Die interne Verlinkung ist ein weiterer entscheidender Faktor für den Erfolg einer Website. Jede Seite sollte mit eindeutigen und bestenfalls keywordoptimierten Ankertexten verlinkt werden, damit Suchmaschinen den inhaltlichen Schwerpunkt der jeweiligen Seite erfassen können. - Keyword und Themen Fokus

Aus SEO-Sicht stellen Keywords (deutsch: Suchbegriffe, Schlüsselwörter, Schlagworte) nach wie vor sehr wichtige Elemente auf einer Seite dar. Eine Suchmaschine ermittelt mittels eines Keyword Analyser die Relevanz eines Dokuments und prüft, ob die jeweilige Seite mit der Suchanfrage übereinstimmt. Wichtige Suchbegriffe sollten im Title-Tag, in der Meta-Description, in den Überschriften und im Content untergebracht werden, damit ein Keyword Fokus entsteht. - Core Web Vitals / Ladezeiten

Die Ladezeiten wurden als Rankingfaktor bei Google durch die Core Web Vitals ersetzt, die das Nutzererlebnis ganzheitlicher messen und bewerten. Sie umfassen verschiedene Aspekte der Website-Performance, darunter die Ladezeit des Hauptelements, die Interaktivität und die visuelle Stabilität der Inhalte. Google hat diese Metriken eingeführt, um Webmastern konkrete Hinweise zur Verbesserung der Nutzererfahrung zu geben. Eine optimierte Performance, gemessen an den Core Web Vitals, kann nicht nur das Ranking in den Suchergebnissen positiv beeinflussen, sondern auch die Absprungrate reduzieren. Für Webseitenbetreiber ist es daher unerlässlich, sich mit diesen Metriken auseinanderzusetzen und kontinuierliche Optimierungen vorzunehmen. - Überschriften

Google weist dem Text bzw. den Keywords innerhalb eines Überschriften-Tags eine höhere Relevanz zu. Zudem strukturieren Überschriften im besten Fall den Seiteninhalt für User und für Suchmaschinen gleichermaßen nachvollziehbar. Die Zahl hinter dem H indiziert die absteigende Hierarchiestufe(<H1> bis <H6>) des Tags. Der <H1>-Tag sollte nur einmal pro Seite gebraucht werden und sich inhaltlich seitenweit nicht wiederholen. - Meta-Description

Im Description-Tag kann eine Seitenbeschreibung hinterlegt werden. Ist diese gutgeschrieben und beinhaltet sie das durch den Nutzer gesuchte Keyword, wird sie von den Suchmaschinen in der Regel als Zusammenfassung in den Suchergebnissen benutzt. Eine saubere und verständliche Seitenbeschreibung in der richtigen Länge führt zu einer höheren Klickrate und kann über diese User-Signale auch zu besseren Rankings führen. - Mobile Optimierung

Bei Google gilt schon seit einiger Zeit: Mobile First! Neben der reinen mobilen Optimierung ist Responsive Design zu einem unverzichtbaren Standard in der heutigen Webentwicklung geworden. Es sorgt dafür, dass Websites auf unterschiedlichen Endgeräten – vom Desktop über das Tablet bis hin zum Smartphone – optimal dargestellt werden. Ein gut umgesetztes Responsive Design passt sich automatisch an die Bildschirmgröße des jeweiligen Endgerätes an und sorgt für ein intuitives Nutzererlebnis. Dies trägt nicht nur zur Benutzerfreundlichkeit bei, sondern wird auch von Suchmaschinen positiv bewertet. In Zeiten, in denen die Mehrheit der Webnutzer über mobile Endgeräte auf Inhalte zugreift, ist es daher unerlässlich, sowohl eine mobile Optimierung als auch ein responsives Design zu implementieren, um im digitalen Wettbewerb bestehen zu können. - HTTPS und Sicherheit

Die Sicherheit von Websites ist nicht nur für Suchmaschinen wie Google ein zentrales Thema, sondern auch für Behörden. Seit dem Inkrafttreten der Datenschutz-Grundverordnung (DSGVO) am 20. Mai 2018 interpretieren einige Behörden die Verordnung so, dass HTTPS für alle kommerziellen Websites verpflichtend ist. Websites ohne SSL-Verschlüsselung werden heute von vielen Browsern als „unsicher“ gekennzeichnet. Gehackte Websites sind immer von Rankingverlusten bedroht. Ein Sicherheitskonzept für die Website sollte daher über HTTPS hinausgehen.

Häufige Fragen zum Thema SEO

In der Praxis werden wir nicht selten mit grundsätzlichen Fragen zum Thema SEO-Optimierung konfrontiert. Sowohl SEO-Einsteiger als auch Fortgeschrittene wenden sich häufig an uns, um zu erfahren, was sich hinter bestimmten Technologien, Begriffen und Vorgehensweisen verbirgt und wie man seine Suchmaschinenoptimierung weiter verbessern und aktuell halten kann. Im Folgenden beantworten wir 3 der Fragen, die uns in letzter Zeit am häufigsten gestellt wurden.

Was ist holistischer Content und kann ich damit mein Google Ranking verbessern?

Holistisch bedeutet „das Ganze betreffend“, mit holistischem Content sind also ganzheitliche Inhalte gemeint. Seit einigen Jahren wird im Bereich SEO viel von ganzheitlichem oder holistischem Content gesprochen. Holistischer Content bedeutet im Zusammenhang mit einer SEO-Optimierung, dass ein Text nicht nur ein Keyword behandelt, sondern das gesamte Themengebiet, in dem das Keyword seinen Ursprung hat.

Inwieweit möglichst umfangreiche Texte zu einem Thema zielführend sind, um u.a. das Google-Ranking zu verbessern, ist in der SEO-Welt umstritten. Fakt ist, dass die Wortanzahl auf den bestplatzierten Landingpages seit Jahren kontinuierlich steigt. Und meist ranken diese Seiten für verschiedene Suchbegriffe zum gleichen Thema gut. Allerdings ist die Wortanzahl auf den Top-Seiten in der mobilen Suche etwas geringer.

Wortanzahl auf rankenden Landingpages – Quelle: Searchmetrics Studie zu Rankingfaktoren 2016.

Es ist aber auch durch verschiedene Studien belegt, dass die Aufmerksamkeitsspanne des normalen Internetnutzers bzw. Online-Shop-Besuchers vergleichsweise gering ist. Wie kann man also den Suchmaschinen-Trend zu längeren Texten mit der mangelnden Geduld der User verbinden? Am besten, indem man auch längere Texte durch Überschriften, Bulletpoints, Hervorhebungen, Links, evtl. auch Grafiken und Videos snackable, also leicht konsumierbar macht. Überschriften helfen – wie bereits erwähnt – auch Suchmaschinen, Inhalte besser zu verstehen und einzuordnen.

Wie eine weitere Searchmetrics Rankingfaktoren-Studie für den Bereich E-Commerce zeigt, ist strukturierter Content auf E-Commerce-Seiten deutlich häufiger anzutreffen als im Durchschnitt aller in den deutschen Top-Ergebnissen gerankten Landingpages. E-Commerce-Seiten weisen nicht nur häufiger überhaupt eine Liste auf (Top 20: 68 Prozent) als der Durchschnitt aller Top-Seiten (Top 20: 61 Prozent), die Listen sind auch länger. Während die branchenübergreifenden Seiten in den Top 10 Suchergebnissen 11,5 Bullets pro Liste aufweisen, haben die entsprechenden eCommerce-Seiten im Durchschnitt maximal 14,7 Bullets pro Liste.

Bullets auf rankenden eCommerce Landingpages – Quelle: Searchmetrics eCommerce Ranking-Faktoren 2017

Als Fazit lässt sich festhalten, dass es heute nicht mehr sinnvoll ist, für unterschiedliche Wortfolgen, Synonyme und Füllwörter, aber auch für sehr ähnliche Keywords separate Seiten anzulegen. Denn moderne Suchmaschinen erfassen auch die Bedeutung von Begriffen und verstehen inzwischen recht gut, was der Inhalt einer Seite ist. Inhalte dürfen also gerne länger sein, wenn sie ein echtes Informationsbedürfnis der Leser befriedigen. Dabei sollten die Inhalte so aufbereitet sein, dass sie für den Nutzer leicht zu scannen sind, damit er das, was ihn wirklich interessiert, auch leicht findet.

Dabei ist es jedoch wichtig, den Fokus nicht aus den Augen zu verlieren und nicht einfach wahllos verschiedene Themen auf einer Seite zu behandeln. Der Fokus wird bis zu einem gewissen Grad bereits durch den Title-Tag und die Meta-Description, das sogenannte Snippet, vorgegeben, in dem nicht beliebig viele Informationen / Themen untergebracht werden können. Das Snippet ist sozusagen das Schaufenster einer Website in den Suchergebnissen und nach wie vor von großer Bedeutung im SEO.

Ein guter Text ist in jedem Fall:

- komplett einzigartig (unique)

- auf die Zielgruppe(n) ausgerichtet

- strukturiert (Überschriften, Bulletpoints & Co.)

- korrekt in Rechtschreibung und Grammatik

- suchmaschinenoptimiert und ggf. auch multimedial

Was sind die Core Web Vitals?

Die Core Web Vitals sind eine Initiative von Google zur Verbesserung der Nutzererfahrung im Web. Diese Metriken messen verschiedene Aspekte der Nutzererfahrung, darunter Ladezeit, Interaktivität und visuelle Stabilität. Hauptziel ist es, Entwicklern und Webmastern konkrete Kriterien an die Hand zu geben, mit denen sie die Performance ihrer Websites überwachen und verbessern können.

Die wichtigsten Metriken der Core Web Vitals

- Largest Contentful Paint (LCP)

- First Input Delay (FID)

- Cumulative Layout Shift (CLS)

Warum sind die Core Web Vitals wichtig?

Die Bedeutung der Core Web Vitals kann nicht hoch genug eingeschätzt werden. Google hat immer betont, dass die User Experience im Mittelpunkt steht. Mit der Einführung der Core Web Vitals gibt Google Webmastern nun klare Richtlinien an die Hand, was ein gutes Weberlebnis ausmacht.

Der Zusammenhang zwischen Ladezeit und Core Web Vitals

Die Ladezeit einer Website ist nach wie vor ein wichtiger Faktor für die Nutzererfahrung und das SEO-Ranking. Aber während die Ladezeit misst, wie schnell eine Webseite geladen wird, bieten die Core Web Vitals eine breitere Perspektive. Sie berücksichtigen nicht nur die Ladezeit, sondern auch andere Aspekte der Nutzererfahrung wie Interaktivität und visuelle Stabilität.

Der Core Web Vitals Report in der Google Search Console

Der Core Web Vitals Report in der Google Search Console bietet Webmastern wertvolle Einblicke in die Performance ihrer Websites. Der Bericht zeigt, wie Websites in Bezug auf die Core Web Vitals abschneiden, basierend auf echten Nutzerdaten. Der Bericht kategorisiert URLs nach ihrem Status (schlechte, zu optimierende, gute) und nach der Art der Metrik (LCP, FID, CLS).

PageSpeed Insights: Ein Einblick in die Seitenleistung

Um eine tiefere und genauere Analyse der Website-Performance zu ermöglichen, bietet Google das Tool PageSpeed Insights (PSI) an. Durch die PageSpeed Insights API können Webmaster die Leistung ihrer Webseiten auf mobilen und Desktop-Geräten prüfen und Optimierungsvorschläge erhalten.

Lab- und Felddaten

PSI verwendet sowohl Lab- als auch Felddaten, um eine ganzheitliche Ansicht der Seite bereitzustellen. Während Labdaten in einer kontrollierten Umgebung erfasst werden und zur Behebung von Leistungsproblemen beitragen, bieten Felddaten einen Einblick in die tatsächliche Nutzererfahrung. Das Tool berücksichtigt Daten wie den First Contentful Paint (FCP) und den First Input Delay (FID), um die Geschwindigkeit und Interaktivität einer Website zu beurteilen.

Leistungsbeurteilung

Anhand der Labdaten berechnet PSI einen Leistungsfaktor für eine Seite, welcher mit Hilfe von Lighthouse analysiert wird. Dieser Faktor wird dann klassifiziert: Ein Faktor von mindestens 90 wird als „schnell“ eingestuft, zwischen 50 und 90 als „durchschnittlich“ und ein Faktor unter 50 als „langsam“.

Verteilung der Messwerte

Ein weiteres nützliches Feature von PSI ist die Verteilung der Messwerte, die den Entwicklern zeigt, in welchem Bereich die FCP- und FID-Werte für ihre Seite liegen. Dies ermöglicht es, die Performance aus unterschiedlichen Blickwinkeln zu betrachten und gezielte Verbesserungen vorzunehmen.

Verständnis der Daten

Es ist wichtig zu betonen, dass es Unterschiede zwischen den Felddaten in PSI und den Daten im Bericht zur Nutzererfahrung in Chrome gibt. PSI-Daten werden täglich aktualisiert, während der Datensatz in BigQuery monatlich erneuert wird.

Labdaten und Lighthouse

Bei der Analyse mit Lighthouse werden verschiedene Performance-Messwerte erfasst und bewertet. Es werden Empfehlungen gegeben, wie die Performance verbessert werden kann, und es wird überprüft, inwieweit die Seite den Best Practices der Webentwicklung entspricht.

Fazit:

Die Core Web Vitals sind ein wichtiger Schritt von Google, um das Web zu einem besseren Ort für alle Nutzer zu machen. Sie geben Webmastern klare Richtlinien an die Hand, um ihre Websites zu verbessern und den Nutzern eine bessere Erfahrung zu bieten. Es ist wichtig, dass Webmaster diese Metriken ernst nehmen und kontinuierlich an der Verbesserung ihrer Websites arbeiten.

Wie funktioniert HTTPS und wie stelle ich von HTTP auf HTTPS um?

Heutzutage verwenden viele Websites HTTPS als Standard. Grundsätzlich sind bei der Umstellung von HTTP auf HTTPS zahlreiche Punkte zu beachten, um sowohl die Sicherheit der Website-Besucher zu gewährleisten als auch negative Auswirkungen auf das Suchmaschinen-Ranking zu vermeiden.

Warum HTTPS wichtig ist

HTTPS bietet eine sichere und verschlüsselte Verbindung zwischen einem Webbrowser und einem Webserver. Dadurch werden die Daten der Nutzer vor potentiellen Angreifern geschützt. Insbesondere für Websites, die sensible Informationen wie Passwörter, Kreditkartendaten oder andere persönliche Daten verarbeiten, ist HTTPS unverzichtbar.

Aktuelle Entwicklungen

Das grüne Schloss und die grüne Adressleiste, die früher als Indikatoren für eine sichere Website galten, werden von modernen Browsern wie Google Chrome und Mozilla Firefox nicht mehr in der gleichen Form angezeigt. Stattdessen gehen viele Browser dazu über, unverschlüsselte Websites explizit als „nicht sicher“ zu kennzeichnen. Umso wichtiger ist es, dass Websites HTTPS verwenden, um das Vertrauen der Nutzer zu erhalten.

Wie HTTPS funktioniert

Wenn ein Benutzer eine HTTPS-Website aufruft, findet ein „Handshake“ zwischen dem Browser des Benutzers und dem Server statt. Während dieses Handshakes tauschen Browser und Server Zertifikate und Schlüssel aus, um eine sichere Verbindung herzustellen. Ein SSL-Zertifikat ist unerlässlich, um eine Website mit HTTPS zu verschlüsseln. Es enthält den öffentlichen Schlüssel der Website, den Domainnamen, für den es ausgestellt wurde, die digitale Signatur der ausstellenden Zertifizierungsstelle und weitere relevante Informationen. SSL-Zertifikate dienen dazu, die Identität eines Ursprungsservers zu bestätigen und helfen dabei, verschiedene Arten von Angriffen, wie z.B. Domain-Spoofing, zu verhindern.

Typen von SSL/TLS-Zertifikaten

Die Sicherheit von Websites und Webanwendungen ist in der heutigen digitalen Welt von entscheidender Bedeutung. Eine der Schlüsseltechnologien, die zur Sicherung von Webtransaktionen beitragen, ist das SSL-Zertifikat, besser bekannt als TLS-Zertifikat. Es gibt jedoch verschiedene Arten von SSL-Zertifikaten, die alle unterschiedliche Anforderungen erfüllen:

Arten von SSL-Zertifikaten

- Single-Domain-SSL-Zertifikate: Wie der Name schon sagt, gelten diese Zertifikate nur für eine einzige Domain. Sie können nicht zur Authentifizierung anderer Domains verwendet werden, auch nicht von deren Subdomains.

- Wildcard-SSL-Zertifikate: Diese Zertifikate sind für eine Hauptdomain und alle ihre Subdomains gültig. Zum Beispiel, wenn „beispiel.com“ ein Wildcard-SSL hat, dann sind „blog.beispiel.com“ und „shop.beispiel.com“ ebenfalls abgedeckt.

- Multi-Domain-SSL-Zertifikate (MDC): MDCs können mehrere, voneinander unabhängige Domains in einem Zertifikat aufführen. Dies ist besonders nützlich für Unternehmen, die mehrere Domains haben und nicht für jede ein separates Zertifikat erwerben möchten.

Validierungsstufen von SSL-Zertifikaten

Es gibt verschiedene Validierungsstufen für SSL-Zertifikate, je nachdem, wie gründlich die Identität der antragstellenden Organisation überprüft wurde:

- Domain Validation SSL-Zertifikate: Die einfachste Überprüfungsstufe. Hier muss die Organisation nur nachweisen, dass sie die Domain kontrolliert.

- Organization Validation SSL-Zertifikate: Bei dieser Stufe wird die Organisation manuell überprüft. Das SSL-Zertifikat enthält den Namen und die Adresse der Organisation.

- Extended Validation SSL-Zertifikate: Dies ist die gründlichste Überprüfungsstufe. Sie beinhaltet einen vollständigen Backgroundcheck der Organisation. Zertifikate dieser Stufe sind besonders vertrauenswürdig und werden oft von größeren Unternehmen und E-Commerce-Plattformen bevorzugt.

Umstellung von HTTP auf HTTPS

Eine manuelle Einbindung des Zertifikats erfordert technisches Know-how und ist generell nur möglich, wenn man vollen Zugriff auf den genutzten Server hat. Viele Hosting-Provider übernehmen die Umstellung, sodass man sein Paket häufig nur upgraden bzw. eine Aktivierung vornehmen muss, und / oder stellen eine detaillierte Installationsanleitung zur Verfügung. Grundsätzlich sollte immer darauf geachtet werden, dass ein gültiges und aktuelles SSL-Zertifikat vorliegt und die Server-Konfiguration korrekt ist.

SEO Checkliste für den Wechsel auf HTTPS

Um keine Ranking-Verluste durch die Umstellung auf HTTPS zu erleiden, müssen einige Dinge berücksichtigt werden. Hier eine Auswahl der wichtigsten Punkte:

301 Weiterleitungen

Für einen reibungslosen Wechsel auf HTTPS ist es unbedingt notwendig, dass mit der Umstellung 301-Redirects implementiert werden. Hierbei sollte jede HTTP-Seite auf die entsprechende HTTPS-Seite weiterleiten. Wenn keine sonstigen Änderungen an der Website vorgenommen werden, kann das relativ einfach etwa über den Server/Hosting Control Panel oder bei den gängigen Apache-Servern durch Integration eines Code-Schnippsels in die .htaccess-Datei umgesetzt werden.

Ein entsprechender Code zur Integration in die .htaccess kann etwa wie folgt aussehen:

IfModule mod_rewrite

RewriteEngine On

RewriteCond %{HTTPS} off

RewriteRule (.*) https://%{HTTP_HOST}%{REQUEST_URI} [R=301,L]

Wenn der Code-Schnipsel nicht funktioniert, findet man viele weitere Lösungen im Netz, zum Beispiel hier. Auch sollte man immer darauf achten, welche Anweisungen in der .htaccess-Datei bereits vorhanden sind, damit es durch zum Beispiel sich widersprechende Anweisungen nicht zu Problemen kommt.

Wichtig ist, immer gleich zu testen, ob die 301-Weiterleitungen auch funktionieren, um zeitnah reagieren zu können, falls es irgendwo hängt. Weiterleitungsketten sollten vermieden werden, es sollte immer direkt auf die neuen HTTPS-URLS weitergeleitet werden. Hierfür müssen ggf. auch bestehende Weiterleitungen geändert werden.

Mixed Content

Wenn das Zertifikat korrekt implementiert wurde, aber trotzdem ein Warndreieck statt eines grünen Schlosses in der Adresszeile des Browsers angezeigt wird, liegt das meist an Mixed Content, also unsicheren Inhalten auf der Website, die weiterhin unter HTTP erreichbar sind. Um dies zu vermeiden, müssen alle Ressourcen (JS, CSS, Bilder, Videos, PDFs, Webfonts) vorab auch unter HTTPS erreichbar sein. Während für Content Management Systeme wie WordPress und Co. oft entsprechende Plugins zur Verfügung stehen, die die Umstellung aller Ressourcen stark vereinfachen, kann bei komplexen Seiten schon einiges an Nacharbeit an verschiedenen Stellen nötig sein. Hier ein Artikel von Google zum Thema: https://developers.google.com/web/fundamentals/security/prevent-mixed-content/what-is-mixed-content

Canonical Tags, Hreflang und Strukturierte Daten

Ein weiterer häufiger Fehler ist, dass bei vorhandenen rel=“canonical“-Tags die neue HTTPS-Version nicht angegeben wird. Canonical Tags weisen Suchmaschinen an, eine bestimmte Version / URL einer Seite zu bevorzugen. Gleiches gilt für hreflang-Attribute, die bei mehrsprachigen oder länderübergreifenden Webprojekten zum Einsatz kommen. Auch diese müssen natürlich auf die neuen HTTPS-URLs verweisen. Bei rel=“next“ / rel=“prev“, speziellen Auszeichnungen für mobile Versionen oder AMP-Seiten muss ebenfalls auf eine Umstellung geachtet werden. Andere Header-Einträge wie Open Graph oder Base-URL (für relative URLs) sowie Strukturierte Daten müssen selbstverständlich ebenfalls auf HTTPS verweisen.

Interne Verlinkung

Auch die internen Links in der Navigation oder den Fließtexten müssen angepasst werden, sofern sie nicht relativ sind, sondern die ganze Adresse (z. B. http://www.domain.de/seo) enthalten. Das kann ein wenig zeitaufwendig sein, ist aber in der Regel einfach umzusetzen. Für WordPress und Co. gibt es hierzu entsprechende Plugins.

Sitemaps

Auch gern übersehen wird, dass die Sitemap angepasst werden muss. In ihr müssen ebenfalls die neuen HTTPS-URLs ausgewiesen sein. Am besten wird die neue Sitemap, wenn alle anderen Punkte erfolgreich umgesetzt sind, gleich bei der Google Search Console eingereicht. Dazu mehr beim übernächsten Punkt

robots.txt

Grundsätzlich muss auch die robots.txt-Datei unter der neuen HTTPS-URL erreichbar sein. Dabei sollte darauf geachtet werden, dass die HTTPS-URLS nicht für Crawler von Suchmaschinen gesperrt sind. Wenn die robots.txt einen Eintrag zu einer XML-Sitemap verfügt, muss dieser auf die neue HTTPS-Version der Sitemap verweisen.

Search Console und My Business

Wenn die Umstellung erfolgreich war, sollte auch ein neuer Eintrag für die HTTPS-Version der Website bei der Google Search Console angelegt werden, um u. a. den Traffic zu erfassen. Anschließend kann auch für eine schnelle Indexierung der HTTPS-URLs dort auch die neue XML-Sitemap eingereicht werden. Ebenfalls neu einreichen muss man ein eventuell vorhandenes Disavow-File, das für Google schlechte Links kennzeichnet. Ist die Search Console Property mit Google Analytics verbunden, muss eine neue Verknüpfung mit der HTTPS-Property vorgenommen werden. Lokale Websites müssen darauf achten, ihren Google My Business Account zeitnah zu aktualisieren.

Umstellung auf HTTPS aus SEO-Sicht

Die Erfahrung zeigt, dass diese Punkte bei einem SEO Check nach erfolgter Umstellung besonders wichtig sind und immer gleich geprüft werden sollten:

- Haben alle Seiten eine sicheren Verbindung?

- Leiten alle Seiten korrekt von der HTTP auf die HTTPS-Version weiter?

- Enthalten alle Seiten einen korrekten Canonical Tag auf die neue HTTPS-Version und sind die neuen URLs nicht durch die robots.txt gesperrt?

- Erreicht die Website bei einem SSL-Test wie dem von SSL Labs ein A-Rating?

Diese Fragen sollten immer mit „Ja“ beantwortet werden können, und zwar möglichst zeitnah nach der Umstellung auf HTTPS. Die übrigen Punkte können in den meisten Fällen ohne gravierenden Rankingverlust behoben werden. Falls die Probleme nicht selbst gelöst werden können, empfiehlt es sich, einen Spezialisten zu kontaktieren, der schnell weiterhelfen kann.

Welche SEO-Tipps können eine Website auch in Zukunft nach vorne bringen?

Grundsätzlich wird für die Google Suche zu optimieren, zukünftig natürlich nicht leichter, weil Google immer weniger auf die klassischen SEO-Signale achtet und zunehmend zu einem mehr holistischen Verständnis des Inhalts einer Seite oder einer ganzen Website kommt. Zudem gewinnen auch die User-Signale immer mehr an Bedeutung. So ergab schon die letzte branchenübergreifende Searchmetrics Studie aus dem Jahr 2016 einen sinkenden Einfluss von Keywords im Title auf das Google Ranking.

Der Umkehrschluss, jetzt ganz auf eine Keywordoptimierung der Seitentitel und Co. zu verzichten, wäre allerdings völlig falsch. Nach wie vor sind Keywords im Seitentitel ein wichtiges Signal, nicht zuletzt für den User. Denn durch die Verwendung des Suchbegriffs im Seitensnippet kann der User beim Scannen der Ergebnisse schnell und einfach erkennen, dass der Treffer für seine konkrete Suchanfrage relevant ist. Deshalb ist auch eine Keywordverwendung in der Meta-Description immer noch zu empfehlen, obwohl hier schon lange kein direkter Einfluss auf das Ranking mehr besteht. Stattdessen fettet Google Keywords in der Meta-Description und legt damit ganz den Fokus auf den User – ein Trend, der inzwischen die meisten der klassischen Rankingfaktoren erfasst hat.

Die Verwendung von Keywords in Titles, Meta-Descriptions, Überschriften (insbesondere H1) und Content sowie ggf. den ALT-Tags von Bildern und URLs gehört also nach wie vor zu den SEO Grundlagen. Diese sollten bei einer SEO Website auf keinen Fall vernachlässigt werden, auch wenn sie als direkte Ranking-Faktoren zunehmend an Bedeutung verlieren.

3 SEO-Tipps für Fortgeschrittene

Die Benutzererfahrung (UX) weiter verbessern

Die Bedeutung der User Experience wird in Zukunft weiter zunehmen. Um diesem Trend gerecht zu werden, hat sich mit dem Agile Content Development eine neue Disziplin herausgebildet. Dabei handelt es sich um eine technologiegestützte Methode, um wettbewerbsfähige Inhalte zu erstellen und kontinuierlich zu optimieren. Durch die konsequente Einbindung des Nutzers und die Messung der Content Performance wird aus dem linearen Erstellungsprozess ein zyklischer Kreislauf, bestehend aus folgenden Schritten:

-

- Recherche

- Erstellung / Optimierung

- Publikation

- Erfolgskontrolle und Messung

Jedem Websitebetreiber ist zu empfehlen, sich die Daten von Google Analytics genauer anzuschauen und sich einige grundsätzliche Fragen zu stellen. Mit welcher Absicht kommen die Besucher auf meine Seite? Was ist das eigentliche Ziel meiner Landing Page? Will sie informieren, eine Anfrage stellen oder weiterleiten?

Aus Sicht der Suchmaschine ist es vor allem wichtig, dass der Nutzer das angezeigte Ergebnis als relevant empfindet und sich auf der Seite wohl fühlt. Daher ist neben der Klickrate in den Suchergebnissen (CTR) auch die Verweildauer ein sehr wichtiges Kriterium für Google und Co. Egal, ob sich die Besucher der Website durch eine Bildergalerie klicken, ein Video ansehen, sich für die Referenzen interessieren oder ein Produkt bestellen – wenn sie lange auf einer Webseite verweilen, ist das gut für das Ranking. Wiederkehrende Besucher sind natürlich ein großes Lob für den eigenen Webauftritt – und genau das sehen auch die Suchmaschinen so. Daher ist es wichtig, die eigene Website im Hinblick auf die Benutzerfreundlichkeit zu optimieren und zu versuchen, die Besucher durch etwas Besonderes zu binden, auch wenn sich dies nicht sofort auszahlt.

Für Sprachsuche und digitale Assistenten optimieren

Es ist davon auszugehen, dass die Bedeutung von Sprachsuche und digitalen Assistenten wie Google Assistant oder Siri 2024 weiter wächst. Inzwischen erinnern Gespräche mit digitalen Assistenten zunehmend an normale Konversationen, auch die Spracherkennung wird immer besser, jedoch besteht vor dem Hintergrund der Entwicklungen im Bereich der Artificial Intelligence, über die Google-CEO Sundar Pichai bereits Anfang 2018 sagte, sie sein grundlegender als die Erfindung von Feuer oder Elektrizität, hier noch viel Luft nach oben. Neben klassischen Smartphones gewinnen in Hinblick auf die Sprachsuche auch die zahlreichen Smart-Home-Hubs von Google, Apple und Amazon immer mehr an Bedeutung.. In Hinblick auf die SEO Optimierung bedeutet die zunehmende Verbreitung von Sprachsuche und digitalen Assistenten vor allem drei Dinge:

-

-

- der Fokus verschiebt sich weiter weg von Keywords hin zur natürlichen Sprache.

- Longtail Keywords gewinnen immer mehr an Bedeutung

- Es ist zu empfehlen, auch auf Fragen und ganze Sätze zu optimieren

-

Mit einer neuen Generation an Internetnutzern werden zunehmend Keywords wie „Olaf Scholz Alter“ von Fragen wie „Wie alt ist Olaf Scholz?“ verdrängt. Um für Fragen wie diese zu optimieren, sollte man erst eine Potenzialanalyse durchführen, um dann zu überlegen, wie man seinen Content am besten entsprechend ergänzen kann.

Jetzt mit Video-Marketing beginnen

Bereits jetzt zählt YouTube zur zweitgrößten Suchmaschine der Welt. Ja, der Wettbewerb ist hart, dennoch lohnt es sich, das Potenzial von Videos für Unternehmen zu erkennen. Immer mehr Personen verbringen ihre Zeit mit Videos, insbesondere auf YouTube, und nutzen diesen Anbieter zur Suche nach Lösungen. Zudem zeigen viele Google-Suchergebnisse Videos. Bei der Erstellung von YouTube-Videos sollte auf Folgendes geachtet werden:

- Mikro-Momente identifizieren, in denen die Interessen der Zielgruppe mit dem Angebot eines Unternehmens zusammenfallen. Täglich suchen Millionen von Menschen auf YouTube nach Videos, die ihren Vorlieben, Wünschen und Interessen entsprechen. Tools wie das io ermöglichen das Herausfinden der wichtigsten Suchanfragen zu einem Thema. Es sollte reflektiert werden, welche Fragen und Bedürfnisse Kunden haben und an welchem Punkt der Customer Journey ein Video hilfreich sein könnte.

- Nützliche Inhalte bereitstellen, die Antworten auf die Probleme und Fragen potenzieller Kunden geben. Der erste Schritt ist das Erstellen von qualitativem und relevantem YouTube-Content, der zur richtigen Zeit die passende Lösung bietet. Im zweiten Schritt sollte darüber nachgedacht werden, wie potenzielle Kunden zur richtigen Zeit auf diese Lösungen aufmerksam gemacht werden können. Dies kann über organische Suche oder verschiedene YouTube-Werbemöglichkeiten erfolgen.

- Verstehen, was effektiv ist. Mit Google Analytics lässt sich erkennen, wie die Zielgruppe mit Inhalten interagiert und wo es Optimierungspotenzial gibt. Dadurch können Videos kontinuierlich verbessert und die Ergebnisse gemessen werden. Dies ermöglicht die Erstellung von immer besseren Videos und die Anpassung der Strategie. Mit Analytics lassen sich auch Daten über die Zuschauer und deren Eigenschaften sammeln. Passen Alter, Geschlecht und Standort zur gewünschten Zielgruppe? Falls nicht, können Inhalte und Werbestrategien angepasst werden, um die passende Zielgruppe besser anzusprechen.

Best Practices für Suchmaschinenoptimierung von Videos

Videos gewinnen immer mehr an Bedeutung im Web. Google indexiert Videos von unzähligen Websites, so dass Nutzer sie leicht auffinden können. Dabei können Videos an verschiedenen Orten innerhalb von Google angezeigt werden.

Optimierung der Videoauffindbarkeit

- Es ist wichtig, dass Videos auf einer öffentlichen Webseite verfügbar sind, die nicht durch robots.txt oder andere Mittel blockiert wird.

- Jedes Video sollte eine eigene Seite haben, auf der es prominent dargestellt wird.

- Videos sollten in geeignete HTML-Tags eingebettet werden, wie

- Die Erstellung einer Video-Sitemap hilft Google beim Auffinden von Videos.

Videos von Drittanbietern

Wenn Videos von Plattformen wie YouTube oder Vimeo eingebettet sind, kann Google das Video sowohl auf der eigenen Webseite als auch auf der Plattform des Drittanbieters indexieren.

Indexierung der Videos

- Es ist notwendig, eine hochwertige Miniaturansicht des Videos anzugeben, damit es in den Videofunktionen von Google angezeigt werden kann.

- Strukturierte Daten helfen Google, das Video besser zu verstehen und entsprechend in den Suchergebnissen zu präsentieren.

Videozugriff für Google

Google muss in der Lage sein, Videodateien abzurufen, um den Inhalt zu analysieren und spezielle Funktionen wie Videovorschauen zu aktivieren. Die Search Console gibt inzwischen Anhaltspunkte, ob das der Fall ist.

Unterstützte Videocodierungen

Google unterstützt verschiedene Videodateitypen, darunter MP4, MOV, AVI und viele andere.

Statische URLs

Es ist empfehlenswert, für jedes Video eine eindeutige und statische URLs ohne Parameter zu verwenden.

Spezifische Videofunktionen

Google bietet verschiedene Videofunktionen, einschließlich Videovorschauen und der Funktion „Wichtige Momente“, um den Nutzern ein besseres Verständnis des Videoinhalts zu geben.

Was kann man unter einer WDF*IDF Analyse verstehen?

WDF*IDF-Analysen sind ein Verfahren zur Textoptimierung für Suchmaschinen wie Google. Dabei wird im Gegensatz zur Bestimmung der Keyworddichte (Keyword Density) nicht nur die relative Häufigkeit eines Keywords in einem Text bestimmt, sondern auch von im Zusammenhang mit einen Keyword auftretenden Termen (Wörtern oder Wortkombinationen). Die Verwendungshäufigkeit der Terme in einem untersuchten Text wird in der Regel mit der von toprankenden Seiten abgeglichen. Ziel des WDF*IDF Verfahren ist es, anstelle eines einzelnen Keywords den gesamten Textinhalt des jeweiligen Dokuments bei der Google Suchmaschinenoptimierung zu berücksichtigen.

Grundsätzlich lässt sich mit der WDF*IDF Formel bestimmen, in welchem Verhältnis einzelne Wörter nicht nur innerhalb eines Dokuments bzw. einer Seite, sondern auch im Verhältnis zu allen möglichen Dokumenten gewichtet sind.

WDF

Die WDF*IDF-Formel besteht aus zwei Teilen. Der WDF steht für „Within Document Frequency“. Mit dem WDF-Wert wird ermittelt, wie häufig ein Term in einem Dokument vorkommt. Die „Within Document Frequency“ ist nichts prinzipiell anderes als die Keyworddichte, welche durch einen Logarithmus ergänzt wurde. Diese „Stauchung“ ist der Natürlichkeit unserer Sprache geschuldet und verhindert, dass eine sehr häufige Verwendung des Terms / Keywords den WDF zu stark ansteigen lässt (Quelle: https://karlkratz.de/onlinemarketing-blog/termgewichtung-wdf-idf/).

i=: Terme, für die der WDF bestimmt wird

j=: Dokument (z. B. Website)

L=: Gesamtzahl der Terme in Dokument j

Freq(i, j)=: Häufigkeit des Terms i im Dokument j

Praxisbeispiel:

Ein Term, der 50 Mal (Freq(i, j)) in einem Dokument von 1.000 Termen (L) vorkommt, hat einen WDF-Score von ca. 0,57. Die Keyworddichte / relative Häufigkeit ist in diesem Fall 5 Prozent.

IDF

Mit dem IDF („Inverse Document Frequency“) wird der WDF in Relation zur Gesamtheit des World Wide Web gesetzt. Je mehr Potenzial ein Term hat, das heißt, je weniger Dokumente dieses Keyword bereits enthalten, desto höher ist der IDF. Ein Term wie Impressum hat beispielsweise einen sehr niedrigen IDF-Score, weil er praktisch auf jeder Website vorkommt.

Um den IDF zu berechnen, setzt man die Zahl der Dokumente, welche den Term enthalten, ins Verhältnis zu der Anzahl aller bekannten Dokumente in einem Dokumentkorpus. Auch hier dient der Logarithmus zur Stauchung der Ergebnisse.

i=: Terme, für die der WDF bestimmt wird

ND=: Anzahl aller Dokumente in einem Dokumentenkorpus (stark vereinfacht gesagt: die Summe aller Resultate von Suchmaschinen für alle Terme innerhalb eines Dokuments).

fi=: Anzahl aller Dokumente, die den Term i enthalten

ND ist in der WDF-Theorie ein wenig unbestimmt, theoretisch sind als Dokumentenkorpus auch alle Dokumente des World Wide Web vorstellbar, der Praktikabilität wegen wird sich jedoch in der Regel auf die addierte Anzahl der Suchergebnisse aller in einem Dokument enthaltenen relevanten Terme beschränkt.

Praxisbeispiel:

Um hier noch einmal zu verdeutlichen, was ND eigentlich ist, hier ein kurzes Beispiel:

Angenommen wir haben ein Dokument, welches nur aus zwei Wörtern / Termen besteht: „SEO“ und „Optimierung“.

„SEO“ hat laut Google (Stand: Januar 2018) ungefähr 144.000.000 Treffer

Optimierung besitzt (Stand: Januar 2018) ungefähr 15.200.000 Treffer

ND würde sich in diesem stark vereinfachten Beispiel also wie folgt berechnen:

ND=144.000.000 +15.200.000=159.200.000

In der Regel werden bei der Berechnung des WDF*IDF-Scores bestimmte Stopwörter ausgeklammert und nur sinntragende Terme berücksichtigt.

WDF*IDF Formel

Da mit dem WDF die Relevanz eines Terms / Keywords in einem bestimmten Dokument berechnet wird und der IDF das Potential eines Terms / Keywords in Bezug auf den gesamten Dokumentkorpus widerspiegelt, ermöglicht die Multiplikation von WDF und IDF einen tiefen Einblick in die Gesamtwertigkeit der verwendeten Terme / Begriffe vor dem Horizont des World Wide Web.

WDF*IDF in der Praxis

Soweit zur Theorie: In der Praxis der WDF*IDF Formel / Analyse kommen SEO-Tools zum Einsatz und es dreht sich alles um Vergleichswerte und Proof-Keywords, also die wichtigsten Terme in einem Dokument. Ziel ist es einen WDF*IDF-Wert zu erzielen, der neben dem eigentlichen Keyword auch für die Hauptterme höher ist als der Durchschnitt, aber weniger hoch als die Ausreißer mit dem höchsten WDF, da ansonsten der Text / die Seite von Suchmaschinen als Spam bewertet werden kann.

Hat man sich bei einem WDF*IDF-Tool für ein zu untersuchendes Keyword entschieden, werden die WDF*IDF-Werte auch für alle anderen wichtigen Terme im Zusammenhang mit diesem Hauptkeyword berechnet. Diese Terme kann man auch als Proof-Keywords bezeichnen, da sie Suchmaschinen beweisen können, dass ein Text / eine Seite für einen Suchbegriff relevant ist, weil dort Begriffe vorzufinden sind, die häufiger in diesem Kontext – konkret auf den topplatzierten Seiten – bei diesem Suchbegriff fallen. Die Termgewichtung ermittelt über den WDF*IDF-Score dieser Proof-Keywords sollte dabei natürlich ähnlich ausfallen, wie bei „den besten“ Dokumenten zu diesem Thema / Keyword.

Beispiel

Hauptkeyword „bikini“ (450.000 monatliche Suchanfragen laut Google Ads Keyword Planer)

Für unser Beispiel haben wir Hunkemöller gewählt, die mit der URL https://www.hunkemoller.de/bademode/bikini auf Position 2 ranken

Quelle: https://www.wdfidf-tool.com/

Vorteile des WDF*IDF-Verfahrens für die Suchmaschinenoptimierung

Das WDF*IDF Verfahren kann ein mächtiges Instrument zur SEO Optimierung von Texten darstellen, weil es ermöglicht Texte zu verfassen, die:

- alle wichtigen Begriffe / Unterthemen zu einem Thema enthalten

- frei von Keyword-Spam sind

- einzigartig und innovativ sind, ohne dass der Fokus verloren geht

- sowohl dokumentenspezifische als auch übergreifende Faktoren berücksichtigen

5 Strategische Überlegungen zu Inhalten für 2024

SEO ist nicht nur Google, sondern verschmilzt zunehmend mit Content Marketing. Denn die Suchlandschaft verändert sich ständig. Nutzer wenden sich immer häufiger verschiedenen Plattformen zu, anstatt sich ausschließlich auf Google zu verlassen. Die Sichtbarkeit einer Marke ist in diesem sich verändernden Umfeld von entscheidender Bedeutung. Hier einige Content Trends für 2024

- Auf Erfahrung, Kompetenz, Autorität und Vertrauen setzen (E-E-A-T)

Trotz der Vielfalt der Suchplattformen bleibt Google ein dominanter Akteur. Daher ist es nach wie vor entscheidend, mit den eigenen Inhalten die richtigen Signale an Google zu senden. E-E-A-T sollte im Mittelpunkt der Content-Strategie stehen. Bei der Auswahl der Content-Themen ist zu prüfen, ob die eigene Marke über direkte Erfahrungen oder einzigartige Expertise verfügt. - Verstehen, welche Inhalte erstellt und wo sie platziert werden sollen

Das Verständnis für die Art des Inhalts und die richtige Platzierung ist entscheidend. Der Trend geht zu immer vielfältigeren Arten von Inhalten. Wenn beispielsweise Inhalte auf YouTube und TikTok beliebt sind, sollten man sich mehr auf Videoinhalte konzentrieren. - Plattformspezifische Anpassung von Inhalten

Verschiedene Content-Plattformen haben unterschiedliche Persönlichkeiten und Algorithmen. Die erstellten Inhalte müssen für jede Plattform nativ sein. Inhalte sollten nicht nur einmal erstellt und überall verteilt werden. Sie sollten speziell für jede Plattform erstellt oder angepasst werden. - Strategien zukunftsfähig machen

Eine erfolgreiche Content-Strategie blickt nicht nur in die Gegenwart, sondern auch in die Zukunft. Marken sollten bereit sein, ihre Strategien auf Basis plattformspezifischer Erkenntnisse anzupassen. - Kreativ getriebenes SEO: Kooperationen und Partnerschaften fördern

Die Zusammenarbeit mit Influencern kann die digitale Präsenz einer Marke menschlicher machen. Solche Partnerschaften ermöglichen es Marken, innovative Inhaltsformate und Plattformen zu erkunden und neue Zielgruppen zu erreichen.

Ausblick:

SEO im Jahr 2024 und darüber hinaus dreht sich alles um den Aufbau von Beziehungen. In einer Welt, in der Aufmerksamkeit wertvoll ist, müssen Marken über reine Sichtbarkeit hinausgehen, um effektiv zu verbinden und zu engagieren. Denken Sie daran: Anpassungsfähigkeit ist der Schlüssel in dieser sich ständig verändernden digitalen Welt.

Zusammenfassung: Die Evolution der Suchmaschinenoptimierung – Die Feinheiten für ein besseres Ranking verstehen

SEO (Search Engine Optimization) ist ein sich ständig weiterentwickelnder Prozess. Die wiederkehrenden Änderungen und Aktualisierungen der Suchmaschinen-Algorithmen, insbesondere von Google, zwingen Website-Betreiber und Online-Marketer, ihre Strategien ständig anzupassen und zu überdenken.

OnPage- und OffPage-Optimierung

Die OnPage-Optimierung umfasst alle Maßnahmen, die direkt auf der Website umgesetzt werden, um die Position in Suchmaschinen zu verbessern. Dazu gehören die Optimierung des Inhalts, der Meta-Tags, der URL-Struktur und der internen Verlinkung. Bei der OffPage-Optimierung stehen externe Faktoren wie Backlinks von anderen Websites im Vordergrund.

Google Ranking-Algorithmus

Google aktualisiert regelmäßig seinen Algorithmus. Jede dieser Änderungen kann das Ranking von Websites beeinflussen. Gerade die inzwischen häufigen Core-Updates haben starke Auswirkungen auf Websites. Daher ist es wichtig, auf dem Laufenden zu bleiben und Best Practices zu befolgen.

Nutzersignale und ihr Einfluss

Signale wie die Click-Through-Rate (CTR) und Pogo Sticking können das Google-Ranking beeinflussen. Eine hohe CTR kann darauf hindeuten, dass eine Website für bestimmte Suchanfragen relevant ist. Pogo Sticking hingegen, das schnelle Zurückspringen auf die Ergebnisseite nach dem Anklicken eines Suchergebnisses, kann als Indikator für eine schlechte User Experience interpretiert werden.

Künstliche Intelligenz von Google in der Suche: RankBrain

RankBrain ist ein maschinell lernendes System, das von Google eingesetzt wird, um Suchanfragen genauer zu interpretieren und relevantere Ergebnisse zu liefern. Es zählt zu den zentralen Werkzeugen von Google und kann das Ranking einer Webseite maßgeblich beeinflussen.

Linkaufbau

Backlinks spielen nach wie vor eine zentrale Rolle für das Ranking bei Google. Der Erwerb von qualitativ hochwertigen Backlinks von vertrauenswürdigen und themenrelevanten Webseiten kann das Ranking positiv beeinflussen. Dabei sollte stets auf organische und authentische Linkbuilding-Methoden gesetzt werden, um Abstrafungen zu vermeiden.

Fazit:

SEO bleibt ein facettenreiches und dynamisches Feld. Die genannten Aspekte sind nur ein kleiner Teil der Faktoren, die es zu berücksichtigen gilt, um die Sichtbarkeit einer Website in den Suchmaschinen zu erhöhen. Es bleibt unerlässlich, sich ständig zu informieren, Strategien zu testen und anzupassen, um eine optimale Position in den SERPs (Ergebnisseiten der Suchmaschinen) zu gewährleisten.